Quand la Pénalité Google frappe votre site.

Comment gérer la pénalité Google après avoir identifié ce qui ne va pas.

Etre touché par un changement d’algorithme n’est pas agréable et laisse souvent l’internaute dans une situation de panique!

Dans ce billet je vais prendre mon exemple avec un de mes sites qui a été pénalisé en Juin 2019 (vu la façon brutale de la descente je ne vois que ça).

Ceci est mon expérience personnelle, et est là pour vous donner des pistes si vous êtes touchés vous aussi!

Chaque cas est unique dans la résolution, mais la démarche d’identification est souvent la même.

La découverte de la pénalité.

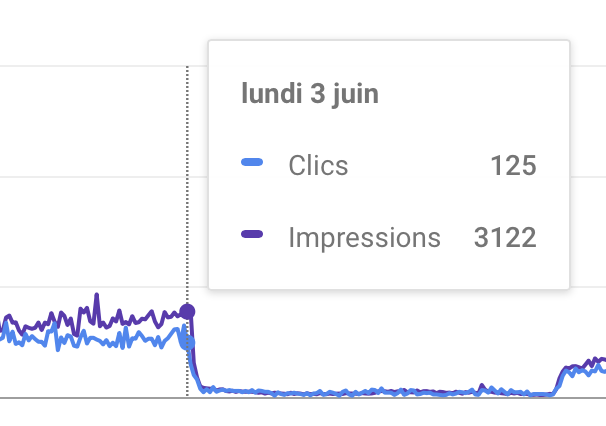

A l’aide de la search console je me rends compte de la baisse brutale de mon trafic le 3 Juin 2019.

Suivant l’actualité SEO je sais que la baisse est liée avec l’algorithme du 3 Juin 2019

on voit bien que la chute est amorcée le 3 juin, et le 7 juin tout est à 0

Identifier la ou les causes

C’est LA partie la plus compliqué du travail car on ne saura en fait jamais la raison exacte de la pénalité (sauf si on a triché mais c’est un autre débat). Il va falloir vous armer de patience et savoir ce qui a été fait en amont.

Et je le répète, c’est vraiment à l’aveugle car comme ce n’est pas une pénalité manuelle on n’a pas la raison.

Regarder les Algorithmes Google passés

C’est un bon début, ça fait réviser et on regarder son contenu. Est-ce que j’ai du contenu dupliqué en masse? est-ce que mon contenu est vide (qualité faible)? Ai-je un soucis d’indexation? Ai-je des liens entrants toxiques?

Plein de points qui en fait amène à faire un audit de son site et regarder ce qui ne va pas.

Voici quelques liens pour regarder un peu tout ça:

SemRush, avec un trial de 15 jours vous aurez le temps de faire un audit de votre site, voir s’il y’a des problèmes! au niveau de vos backlink aussi.

La Google search console, ce sera votre outil principal car quasiment tout est listé dessus.

Screaming Frog est aussi très bon pour avoir une idée de la structure de vote site.

Les points que j’ai regardé

En premier j’ai pensé à des liens entrant toxiques, ce qui était possible car ayant énormément de liens venant de sites Russes qui sont eux même des listing plus ou moins douteux.

Du coup je pensais être sous le coup de Pinguin, avec un nombre élevé de liens négatifs pointant vers moi.

Je décide donc de les désavouer via la search console. On gros on dit à Google de ne pas en tenir compte. Normalement il faudrait demander aux webmaster d’enlever les liens directement du site, mais là, des sites Russes avec aucun contact je n’allais perdre de temps avec.

D’ailleurs Google a dit que ça ne sert à rien de désavouer car Pinguin veille! Mais là fallait quand même tenter!

J’ai ensuite regardé avec Screaming Frog si tout était bon au niveau crawl, et rien d’anormal.

Je m’attaque au contenu de mauvaise qualité, et je regarde aussi la perte de mot clefs. Et je me rends compte qu’il y’a des mots clefs qui sont complètement bizarre depuis pas mal de temps.

Aussi en regardant l’indexation du site, je vois que mon site qui a normalement 800 pages dans les sitemap est entrain de monter, monter, et est à presque 5000 pages dans Google!

Je me dis que je tiens le coupable !

L’erreur technique

En regardant de plus près je vois que le nombre de liens montent depuis quelques semaines et ce au rythme du crawl de Google et Bing. D’ailleurs je me suis rendu compte que Bing indexait beaucoup plus de pages que Google en indexant les pages /feed.

Maintenant il fallait savoir pourquoi j’avais toutes ces pages d’indexées, et ce qui était bizarre que ces pages étaient souvent en 404.

Le coupable

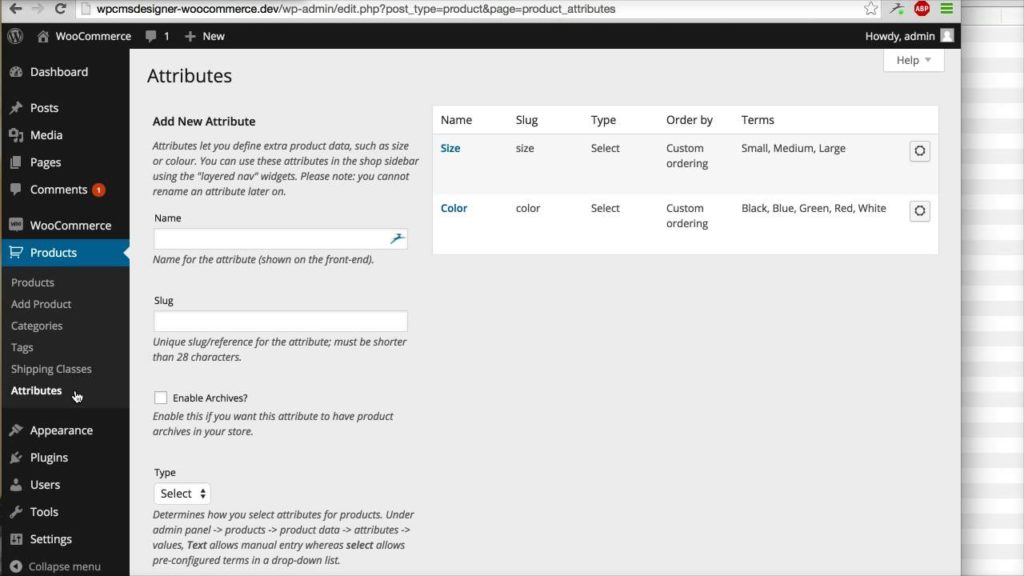

Le site étant un site de E-Commerce chaque produit a plein d’attributs taille, poids et plein de dimensions intermédiaires.

Il y’a longtemps, on avait directement dans wordpress rendu impossible au client de cliquer sur ces liens et donc il était impossible de voir ces « pages » qui en fait sont vides car ce seraient des classement du genre : tous les produits faisant 3kg ou faisant 20cm, ce qui n’avait pas de sens.

Mais où c’était bizarre c’est que ces pages existaient dans Google via les sitemap mais n’étaient pas atteignables par l’internaute (et pas les robots du coup).

Aussi j’avais changé des règles d’indexations 2 mois avant et sur un mauvais click j’avais remis ces pages dans les sitemap!!

Au final des pages avec peu ou pas de valeur pour l’internaute, couplé avec des pages non accessibles par les robots mais étant listé dans les sitemap.

Mon analyse de la pénalité

Comme je disais il est impossible de savoir les raisons exactes des pénalités d’algorithme, mais je pense que pour mon cas Google a vu ces pages comme des Doorway pages (et qui plus est de faible qualité). Des pages en quantités énorme qui sont caché des crawl (aucun lien entrant) mais pointant quand même vers le site.

De plus avec 4 fois le nombre de mes pages normales, il est évident que 75% du site étaient soit des pages vides ou dupliqués

Donc pour Google mon site était devenu un site de spam de mauvaise qualité.

Les corrections apportées

Il m’a fallu revoir les règles des noindex par robots (maintenant Google ne regarde plus les robots.txt) et attendre que le site reprenne une taille normale.

Il a fallu bien 2 mois pour épurer toutes ces pages même si manuellement j’ai demandé à Google de les enlever de l’index.

Et puis un jour tout est revenu mais avec des pertes. Il faudra attendre encore quelques mois pour revenir au trafic pré-pénalité.

En conclusion

Si vous êtes touchés vous aussi, regardez :

- Audit technique de votre site

- Les derniers Algorithmes Google voir si ça colle avec la baisse

- Ne pas baisser les bras et continuer de proposer du contenu de qualité tout en corrigeant votre site.

Il n y’a pas de remède miracle sinon tout le monde utiliserait la même recette. Le SEO est un marathon ! et pensez toujours à l’internaute en 1er.

Si vous avez des questions/commentaires n’hésitez pas à répondre.